Problematische Gesichts- und Spracherkennung: Diese Anwendungen wollen Forschende in der Schweiz verbieten

Zahlungen kann man längst per Gesichtserkennung auf dem Handy freigeben, digitale Assistenten wie «Alexa» spielen auf Zurufen hin Musik ab oder Türen lassen sich ohne Schlüssel öffnen. Was einst wie Stoff aus Science-Fiction-Filmen klang, ist längst Realität. Die automatische Stimm-, Sprach- und Gesichtserkennung setzt sich im Alltag immer stärker durch.

Das bringt viele Vorteile mit sich. Doch die automatische Erkennung von biometrischen Daten birgt auch Missbrauchpotenzial. Eine am Dienstag publizierte Studie im Auftrag der Stiftung Stiftung für Technologiefolgen-Abschätzung (TA-Swiss) zeigt, welche Chancen und Risiken beim Einsatz dieser Technologien bestehen. Zudem spricht sie eine Reihe von Empfehlungen für deren Gebrauch aus. Die Studie wurde gemeinsam vom Fraunhofer-Institut für System- und Innovationsforschung ISI in Karlsruhe und vom Institut für Europarecht der Universität Freiburg (Schweiz) durchgeführt.

Krankheiten präventiv erkennen

Die Forschenden attestieren zwar, dass sogenannte smarte Lautsprecher beispielsweise Menschen mit einer körperlichen Behinderung den Alltag erleichtern können. Oder die Gesichtserkennung könne aktuell in der Ukraine helfen, Vermisste zu suchen und Tote zu identifizieren.

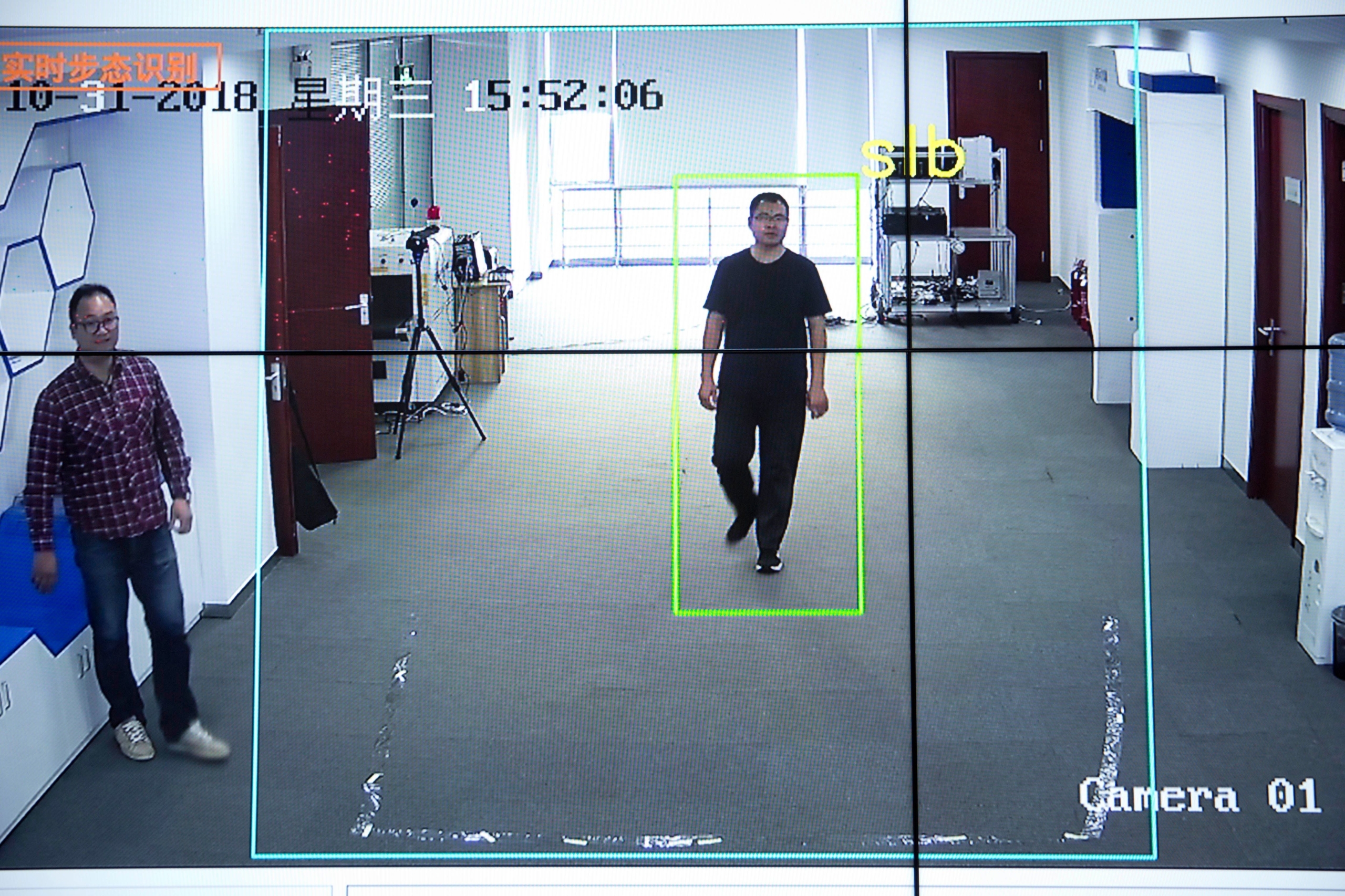

Weiter erhoffen sich Mediziner, dass Stimm-, Sprach- und Gesichtserkennungen dereinst dazu beitragen werden, Krankheiten wie Parkinson, Alzheimer, Depressionen oder Burn-outs frühzeitig aufzudecken. Darüber hinaus könnten Technologien zur automatischen Erkennung von Stimme, Sprache und Gesicht auch die öffentliche Sicherheit erhöhen. Etwa indem Verdächtige aufgespürt und ihr Handeln verfolgt werden kann.

Technologien akzentuieren Machtgefälle

Gleichzeitig betonen die Forschenden in der Studie im Auftrag der TA-Swiss die Risiken hinter der automatischen Erkennung von biometrischen Daten. Seien diese beispielsweise einmal gehackt, «bleiben sie dauerhaft kompromittiert». Zudem hält die Studie fest:

«Der Einsatz der Stimm-, Sprach- und Gesichtserkennung gefährdet die Privatsphäre, weil sie die Menschen aus ihrer Anonymität holt.»

Smarte Lautsprecher stünden beispielsweise oft im Mittelpunkt des Haushaltes. «Sie sind ständig auf Empfang und zeichnen unter Umständen vertrauliche Informationen auf.» Weiter würden die Technologien das «Machtgefälle zwischen staatlichen Stellen beziehungsweise privatwirtschaftlichen Anwendern und den Bürgerinnen und Bürgern» herausstreichen.

Vor allem, wenn sich die Bürger nicht im Klaren sind, über welche Daten die Behörden oder privatwirtschaftlichen Akteure über sie verfügen. Als Beispiel führen die Forschenden den Skandal um die US-Firma Clearview AI auf. Das 2017 gegründete Unternehmen sammelte öffentlich sichtbare Bilder unter anderem von Instagram und stellte auf dieser Basis eine Datenbank zur Gesichtserkennung zusammen. Diesen Dienst stellte die Firma dann weltweit staatlichen und privaten Stellen zur Verfügung – ohne die Eigentümer der Bilder zu informieren.

Flächendeckende Überwachung im öffentlichen Raum

Die Forschenden fordern deshalb in ihrer Studie, dass gewisse «hoch riskante Anwendungen» in der Schweiz verboten werden. Dazu zählen sie etwa den Einsatz von Gesichtserkennungstechnologie für eine flächendeckende Echtzeitüberwachung. Diese wird etwa von der russischen Polizei in Moskau seit 2017 eingesetzt.

Ebenso verboten gehört laut den Forschenden die Einrichtung eines Systems von Sozialkrediten. Solche Systeme, welche auf Grundlage einer flächendeckenden Überwachung das Wohl- oder Fehlverhalten der Bürger bewerten, laufen bereits in mehreren chinesischen Städten als Versuch. Ende 2021 forderten in der Schweiz die Digitale Gesellschaft zusammen mit Amnesty International und Algorithmwatch CH mit einer Petition ein ähnliches Verbot wie nun die TA-Swiss in ihrer Studie.

Weiter kommt die Stiftung darin zum Schluss, dass der Einsatz von biometrischen Erkennungssystemen für sogenannte Aufmerksamkeitsanalysen an Schulen verboten gehören ebenso wie vollautomatische Entscheidungssysteme im Gesundheits-, Banken- und Versicherungswesen, in der Strafverfolgung oder am Arbeitsplatz.

Es braucht eindeutige Gesetze

Damit Gesichts-, Stimm- und Sprachbiometrie vertrauenswürdig eingesetzt werden können, braucht es laut den Forschenden eindeutige gesetzliche Rahmenbedingungen. Sie plädieren dafür, dass …

«… Notwendigkeit und Zweck des Einsatzes präzise genannt und die Bearbeitung der Daten auf das strikt Notwendige beschränkt bleiben.»

Weiter sollen die Betroffenen der Erhebung von biometrischen Angaben zustimmen oder sie verweigern können, ohne dafür Nachteile fürchten zu müssen. Zudem sollen Fachstellen eingerichtet werden, an die sich Personen wenden können, wenn sie sich vor den Nachteilen der Technologien schützen und ihre Rechte durchsetzen möchten.

Den Entwicklern und Herstellern von biometrischen Erkennungssystemen empfehlen die Autorinnen und Autoren wiederum, die erhobenen Daten, wenn immer möglich, nur in den Geräten selber zu speichern und zu verarbeiten. «Dadurch liessen sich sowohl der Datenschutz als auch die Verfügungsgewalt der Nutzerinnen und Nutzer über die eigenen Daten stärken», heisst es in der Studie.

Anstoss zu gesellschaftlicher Debatte

Schliesslich sprechen sich die Forschenden dafür aus, dass eine gesellschaftliche Debatte über die Vor- und Nachteile der Stimm-, Sprach- und Gesichtserkennung geführt wird, und darüber, was bei den Technologien erlaubt und was verboten sein soll.

TA-Swiss ist eine gemeinnützige Stiftung, welche den Auftrag hat, Chancen und Risiken neuer Technologien zu untersuchen. Sie wird laut eigenen Angaben ausschliesslich durch öffentliche Mittel finanziert und gehört organisatorisch zu den Akademien der Wissenschaften Schweiz.